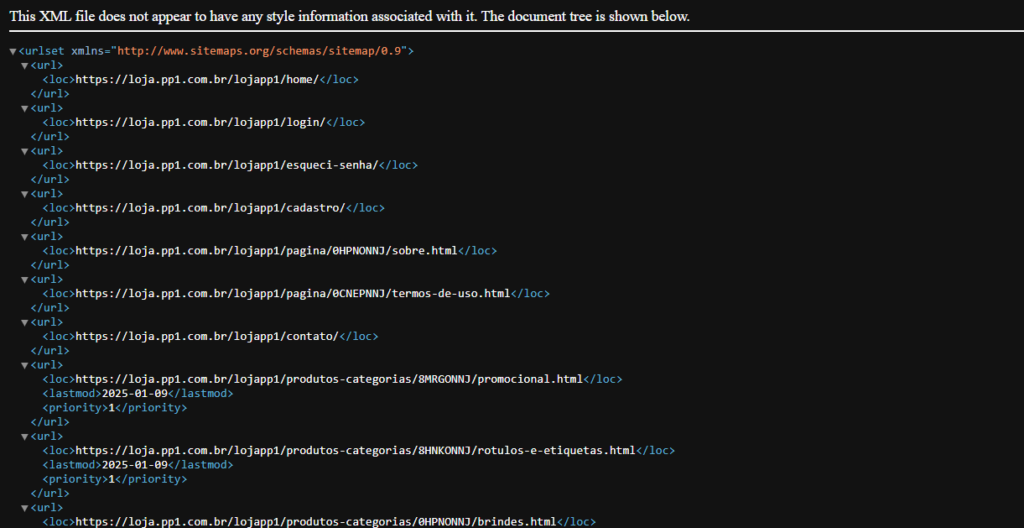

Um sitemap é um arquivo em formato XML que contém uma lista organizada de páginas e conteúdos de um site. Ele atua como um guia para os motores de busca, facilitando a indexação e a compreensão da estrutura do site. Em outras palavras, é como um mapa que ajuda os motores de busca a navegar eficientemente pelo seu conteúdo.

Além de informar quais páginas estão disponíveis para indexação, o sitemap pode fornecer informações adicionais, como a frequência de atualização das páginas e a importância relativa de cada uma.

Um sitemap, também conhecido como mapa do site, é uma estrutura organizada e hierárquica de links que enumera todas as páginas e recursos de um site da web. Sua finalidade é facilitar a navegação tanto para os motores de busca, como o Google, quanto para os visitantes humanos.

O Sitemap da Loja é concebido como um documento dinâmico, sendo atualizado automaticamente a cada modificação realizada na loja. Essa abordagem garante que os registros estejam sempre atualizados e reflitam com precisão a estrutura e o conteúdo em evolução da loja.

O link para acessar o sitemap em formato XML está disponível em:

http://dominiodaloja.com.br/nomedaloja/rss/sitemap

Utilize este link para integrar de maneira eficiente a estrutura e o conteúdo da sua loja com os motores de busca, otimizando a indexação e melhorando a experiência de navegação para os usuários.

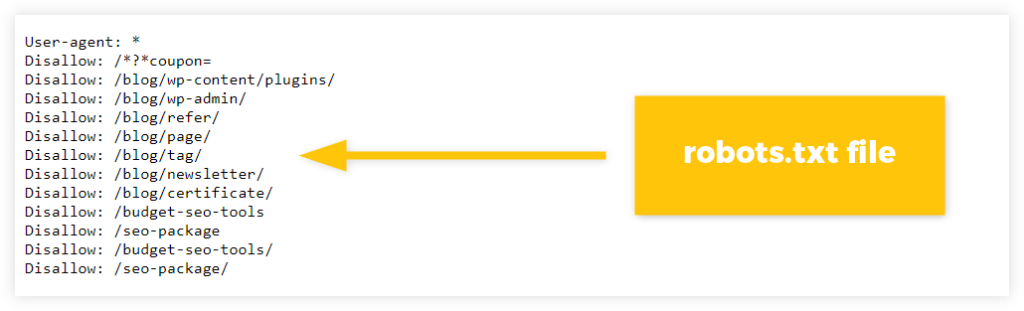

O arquivo “robots.txt” é um componente textual vital utilizado para fornecer instruções aos motores de busca e outros bots da web, delineando quais seções de um site estão autorizadas para rastreamento e indexação. Em termos simples, o “robots.txt” funciona como um conjunto de diretrizes que especifica aos bots da web quais páginas ou diretórios podem ser acessados e quais devem ser excluídos.

Na raiz da plataforma, não existe um arquivo “robots.txt”, com a exceção da pasta /admin, a qual restringe e bloqueia a indexação dos arquivos localizados no painel administrativo. É importante observar que os buscadores, por padrão, têm permissão para indexação de forma nativa, independentemente da presença do arquivo “robots.txt”.

Além disso, há considerações adicionais a serem feitas quando se trata de plataformas que suportam múltiplas lojas em um ambiente compartilhado. Isso pode acarretar desafios relacionados às regras contidas no arquivo “robots.txt”, especialmente quando há informações sobre sitemaps. Por exemplo, se um sitemap estiver endereçado para um projeto que engloba mais de uma loja, é possível que haja variações no endereço da URL.

No entanto, para contornar essas complexidades, os gestores de marketing têm a opção de enviar o arquivo “robots.txt” com os parâmetros desejados para que a PP1 possa hospedá-lo na raiz da loja. As instruções detalhadas para a criação do arquivo podem ser encontradas em: https://rockcontent.com/br/blog/robots-txt/ ou https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt?hl=pt-br. Esses recursos fornecem uma compreensão mais profunda e orientações claras sobre a configuração do “robots.txt”.